新增实时数据同步任务

平台支持实时数据同步任务的新建。实时数据同步任务支持的数据源类型为MySQL、Oracle、SQL Server、PostgreSQL、Kafka。本文以同步MySQL数据源到Kafka目标端为例,介绍如何新增实时数据同步。

前提条件

- 已存在对应数据源。

- 已添加实时数据同步任务目录。

�操作步骤

-

登录 Uniplore Data Studio 平台。

-

在左侧菜单,单击数据同步菜单,选择实时数据同步菜单。

-

在实时数据同步页面,单击新增任务。

-

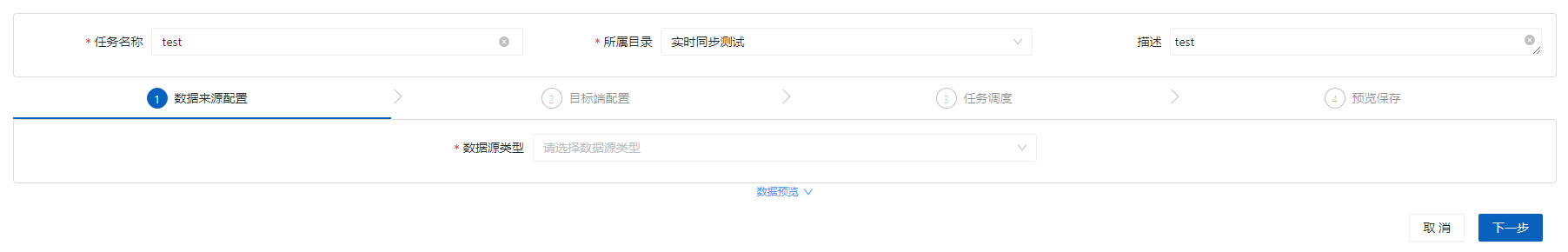

配置数据源 a. 在数据源配置区域,选择数据源类型、数据源、数据对象、数据操作、格式转化,任务类型、是否分表、采集起点等配置。

说明

- 任务类型、是否分表、采集起点已设默认值,后续将支持更多操作。

- 如果格式转化选择“嵌套JSON平铺”,多层嵌套格式的JSON分解为单层结构,例如:

{"a":1, "b": {"c":3}}, 将会被分解为:{"a":1,"b_c":3}。 b. 配置完成后,单击下一步。

-

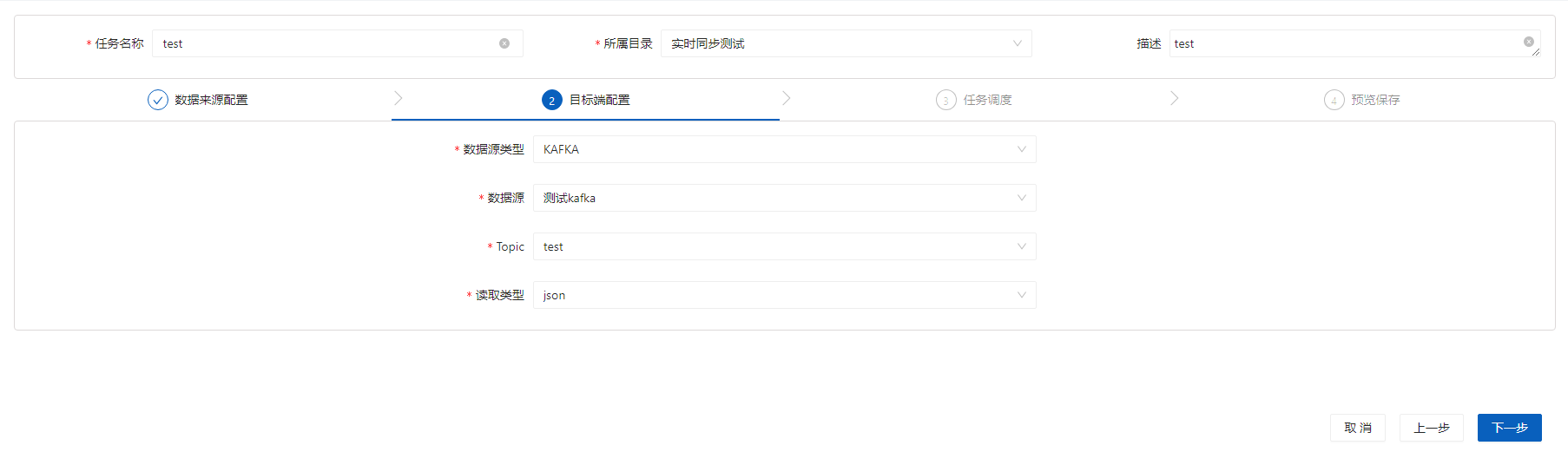

配置目标端。 a. 在目标源配置区域,选择数据源类型(Kafka)、数据源�、topic、读取类型。

b. 配置完成后,单击下一步。

b. 配置完成后,单击下一步。 -

配置任务调度。 a.配置高级配置,配置任务的资源规格、速率。

参数 说明 资源规格 请设置任务实例运行需要的CPU内核(系统默认2个)与内存(系统默认1024 MB)。 速率 设置任务的速率上限,任务运行会尽可能达到该速度但是不是超过它。

通道(个):通道数量上限, 即并发线程数量上限。

字节(byte/s)/通道:每个通道每秒传输的字节流上限。

记录(条/s)/通道:每个通道每秒传输的记录数上限。

说明 字节流和记录数2个上限,谁先达到,谁先起作用。

c. 操作完成后,单击提交,在提示对话框中单击确定。

相关操作

| 操作 | 说明 |

|---|---|

| 查看实时任务 | 在目标实时任务的操作列,单击查看,可查看实时任务详细内容。 |

| 编辑实时任务 | 在目标实时任务的操作列,单击编辑,可对实时任务进行编辑。 |

| 删除实时任务 | 对于未运行的同步任务,在目标同步任务的操作列的更多,选择删除,对同步任务进行删除。 |